重庆Linux培训班

重庆Linux培训班

- 上课时段:详见详情

- 教学点:1个

- 开班时间:滚动开班

- 课程价格:请咨询

- 已关注:841

- 优惠价格:请咨询

- 咨询电话: 400-008-6280

中公优就业Linux云计算培训学员熟悉掌握Linux操作统的安装、配置、相关命令、VIM编辑器、系统管理、服务用和配置,并具有一定的实战能力。课程设置兼顾岗位学习难度、匹配未来就业岗位工作内容、岗位梯度,把学到的运用到工作当中去。

Linux云计算究竟为什么那么火?

百度、阿里巴巴、腾讯等国内排行靠前的互联网公司,大都使用的是Linux系统

百度云 |

滴滴出行 |

| 百度云有百万台服务器为企业提供云计算服务,这些服务都架构在Linux平台上。 | 为了维持每天千万出行用户的使用,滴滴软件要保持极强的稳定性和安全性,这都需要专业的Linux运维工程师。 |

绝地求生 |

抖音 |

| 每一场战斗都需要毫秒级别的数据通信保障,这离不开在背后保驾护航的Linux云计算运维工程师。 | 日活数亿的抖音软件中,数亿的视频都存储在专业的Linux系统存储平台上。 |

多岗位-多领域-多栖发展

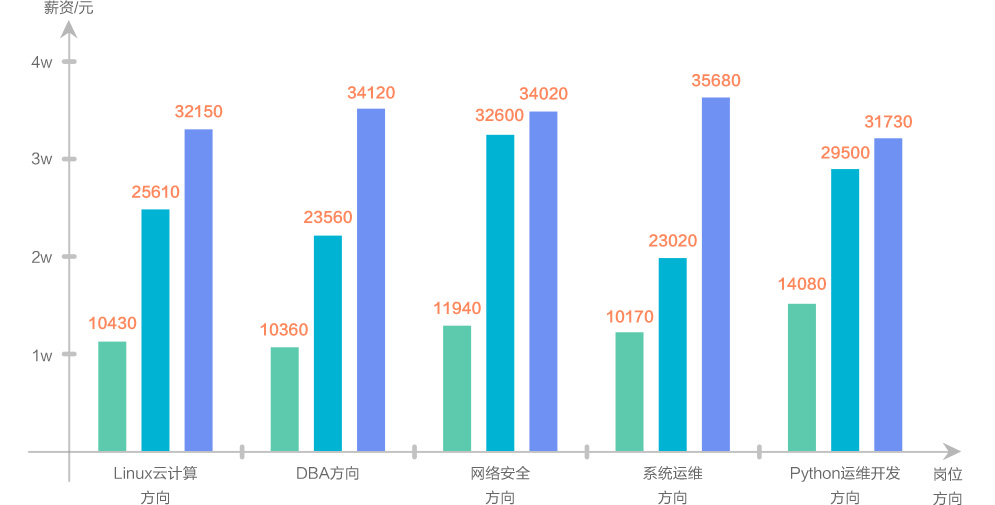

五大职业方向平均薪资(数据来自职友集)

| ||||

| 云计算工程师 | 数据库运维工程师 | 安全运维工程师 | 系统运维工程师 | Python运维开发工程师 |

| 云计算研发工程师 | 高级数据库工程师 | 安全专家 | 高级系统运维工程师 | Python高级运维开发工程师 |

| 云计算架构师 | 数据库架构师 | 安全架构师 | 系统运维技术专家 | 技术总监 |

课程适合人群

零基础人员 |

初高中辍学人员 |

想转行人员 |

薪资低人员 |

晋升无望人员 |

| 自制力强、学习态度好、能坚持,想通过学习改变现状的人员。 | 初中高中毕业后就没有再继续学业的辍学人员。 | 对IT行业感兴趣,想要转行Linux云计算行业的人员。 | 目前薪资较低,但有更远大的抱负的人员。 | 工作多年,却一直苦于无法晋升的人员。 |

精心研磨实用的良心课程

课程兼顾实用与前沿,实时跟进市场动态,实操企业实战项目

网络基础 第一阶段 | 学习内容 通信原理与通信网、 多路访问技术、 以太网通信技术、ISO/OSI开放系统互联模型、常用网络协议 信息编码与进制转换、MAC/IP地址与子网划分、网内网间通信模型 常用网络设备配置 | 企业级项目实战 IP地址配置与DNS解析

|

Linux基础 第二阶段 | 学习内容 计算机工作原理、操作系统基本原理、Linux操作系统 基础、Linux用户管理、Linux文件管理、Linux设备管理 Linux磁盘管理、Linux进程管理、Linux系统启动 Linux高级命令、Linux日常运维 | 企业级项目实战 云数据中心主机CPU资源利用率实时统计、分析系统

|

Linux运维自动化 第三阶段 | 学习内容 Linux系统安全、文件共享服务、网络存储服务 常用网络服务、持续发布与持续集成、服务器集群与 高可用、Shell脚本编程、Python程序开发 | 企业级项目实战 Linux运维项目分布式监控系统部署与运维 1.Python+Shell实现企业级FTP文件统一管理 2.大型数据中心批量部署机器 3《OLG游戏》云平台弹性扩缩容设计与实现;《优选电商》云平台综合部署与日常运维

|

数据库 运维管理 第四阶段 | 学习内容 Linux系统安全、文件共享服务、网络存储服务 常用网络服务、持续发布与持续集成、服务器集群与 高可用、Shell脚本编程、Python程序开发 | 企业级项目实战 Linux运维项目异步消息队列集群部署与运维 1.企业级项目实战:MySQL Galera高可用集群环境部署 2.异步消息队列集群RabbitMQ部署与运维 3.企业ERP综合管理系统数据库设计与性能调优

|

云数据中心综合运维 第五阶段 | 学习内容 虚拟化技术应用、企业云平台部署与管理 混合云与容器技术、云数据中心日常运维 项目实战与职业能力测评 | 企业级项目实战 Linux运维项目容器云平台部署与自动化运维 1.OpenStack虚拟化平台集群模式部署 2.Docker Swarm容器云平台部署与自动化运维 3《OLG游戏》云平台弹性扩缩容设计与实现;《优选电商》云平台综合部署与日常运维

|

就业指导 第六阶段 | 简历制作、面试礼仪 模拟面试

| |

Linux培训资料

Linux内核中的内存屏障

之前读了关于顺序一致性和缓存一致性讨论的文章,感觉豁然开朗。对linux内核中出现的种种同步和屏障,想做一点总结。

缓存一致性

之前一直认为linux中很多东西是用来保证缓存一致性的,其实不是。缓存一致性绝大部分是靠硬件机制实现的,只有在带lock前缀的指令执行时才与cache有一点关系。(这话说得绝对,但我目前看来就是这样)我们更多的时候是为了保证顺序一致性。

所谓缓存一致性,就是在多处理器系统中,每个cpu都有自己的L1 cache。很可能两个不同cpu的L1 cache中缓存的是同一片内存的内容,如果一个cpu更改了自己被缓存的内容,它要保证另一个cpu读这块数据时也要读到这个最新的。不过你不要担心,这个复杂的工作完全是由硬件来完成的,通过实现一种MESI协议,硬件可以轻松的完成缓存一致性的工作。不要说一个读一个写,就是多个同时写都没问题。一个cpu读时总能读入最新的数据,不管它是在自己的cache中,还是在其它cpu的cache中,还是在内存中,这就是缓存一致性。

顺序一致性

所谓顺序一致性,说的则是与缓存一致性完全不同的概念,虽然它们都是处理器发展的产物。因为编译器的技术不断发展,它可能为了优化你的代码,而将某些操作的顺序更改执行。处理器中也早就有了多发射、乱序执行的概念。这样的结果,就是实际执行的指令顺序会与编程时代码的执行顺序略有不同。这在单处理器下当然没什么,毕竟只要自己的代码不过问,就没人过问,编译器和处理器就是在保证自己的代码发现不了的情况下打乱执行顺序的。但多处理器不是这样,可能一个处理器上指令的完成顺序,会对其它处理器上执行的代码造成很大影响。所以就有了顺序一致性的概念,即保证一个处理器上线程的执行顺序,在其它的处理器上的线程看来,都是一样的。这个问题的解决不是光靠处理器或者编译器就能解决的,需要软件的干预。

内存屏障

软件干预的方式也非常简单,那就是插入内存屏障(memory barrier)。其实内存屏障这个词,是由搞处理器的人造的,弄得我们很不好理解。内存屏障,很容易让我们串到缓存一致性去,乃至怀疑是否这样做才能让其它cpu看到被修改过的cache,这样想就错了。所谓内存屏障,从处理器角度来说,是用来串行化读写操作的,从软件角度来讲,就是用来解决顺序一致性问题的。编译器不是要打乱代码执行顺序吗,处理器不是要乱序执行吗,你插入一个内存屏障,就相当于告诉编译器,屏障前后的指令顺序不能颠倒,告诉处理器,只有等屏障前的指令执行完了,屏障后的指令才能开始执行。当然,内存屏障能阻挡编译器乱来,但处理器还是有办法。处理器中不是有多发射、乱序执行、顺序完成的概念吗,它在内存屏障时只要保证前面指令的读写操作,一定在后面指令的读写操作完成之前完成,就可以了。所以内存屏障才会对应有读屏障、写屏障和读写屏障三类。如x86之前保证写操作都是顺序完成的,所以不需要写屏障,但现在也有部分ia32处理器的写操作变成乱序完成,所以也需要写屏障。

其实,除了专门的读写屏障指令,还有很多指令的执行是带有读写屏障功能的,比如带lock前缀的指令。在专门的读写屏障指令出现之前,linux就是靠lock熬过来的。

至于在那里插入读写屏障,要视软件的需求而定。读写屏障无法完全实现顺序一致性,但多处理器上的线程也不会一直盯着你的执行顺序看,只要保证在它看过来的时候,认为你符合顺序一致性,执行不会出现你代码中没有预料到的情况。所谓预料外的情况,举例而言,你的线程是先给变量a赋值,再给变量b赋值,结果别的处理器上运行的线程看过来,发现b赋值了,a却没有赋值,(注意这种不一致不是由缓存不一致造成的,而是处理器写操作完成的顺序不一致造成的),这时就要在a赋值与b赋值之间,加一个写屏障。

多处理器间同步

有了SMP之后,线程就开始同时在多个处理器上运行。只要是线程就有通信和同步的要求。幸好SMP系统是共享内存的,也就是所有处理器看到的内存内容都一样,虽然有独立的L1 cache,但还是由硬件完成了缓存一致性处理的问题。那不同处理器上的线程要访问同一数据,需要临界区,需要同步。靠什么同步?之前在UP系统中,我们上靠信号量,下靠关中断和读修改写指令。现在在SMP系统中,关中断已经废了,虽然为了同步同一处理器上的线程还是需要的,但只靠它已经不行了。读修改写指令?也不行了。在你指令中读操作完成写操作还没进行时,就可能有另外的处理器进行了读操作或者写操作。缓存一致性协议是先进,但还没有先进到预测这条读操作是哪种指令发出来的。所以x86又发明了带lock前缀的指令。在此指令执行时,会将所有包含指令中读写地址的cache line失效,并锁定内存总线。这样别的处理器要想对同样的地址或者同一个cache line上的地址读写,既无法从cache中进行(cache中相关line已经失效了),也无法从内存总线上进行(整个内存总线都锁了),终于达到了原子性执行的目的。当然,从P6处理器开始,如果带lock前缀指令 要访问的地址本来就在cache中,就无需锁内存总线,也能完成原子性操作了(虽然我怀疑这是因为加了多处理器内部公共的L2 cache的缘故)。

因为会锁内存总线,所以带lock前缀指令执行前,也会先将未完成的读写操作完成,也起到内存屏障的功能。

现在多处理器间线程的同步,上用自旋锁,下用这种带了lock前缀的读修改写指令。当然,实际的同步还有加上禁止本处理器任务调度的,有加上任务关中断的,还会在外面加上信号量的外衣。linux中对这种自旋锁的实现,已历经四代发展,变得愈发高效强大。

扫描二维码免费领取试听课程

登录51乐学网

注册51乐学网