太原大数据培训班

太原大数据培训班

- 上课时段:详见详情

- 教学点:1个

- 开班时间:滚动开班

- 课程价格:请咨询

- 已关注:748

- 优惠价格:请咨询

- 咨询电话: 400-008-6280

- 微信咨询:tan4811

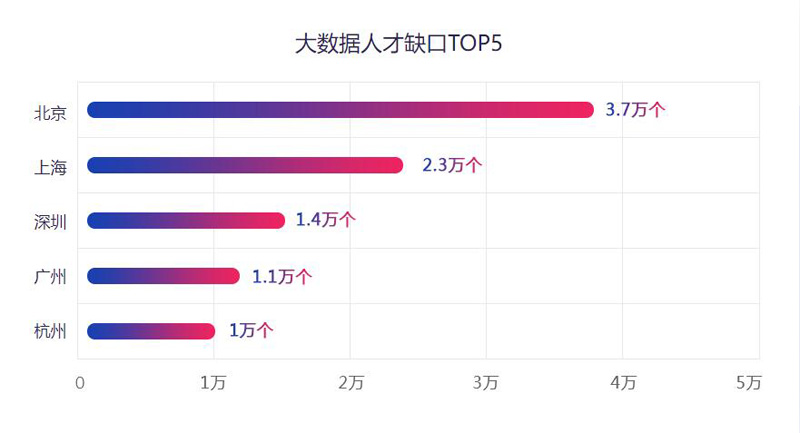

大数据是一种在获取、存储、管理、分析等方面大大超出了传统数据库软件工具能力范围的数据集合。它具有大量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。 未来大数据相关人才缺口巨大。

大量优质岗位等你来

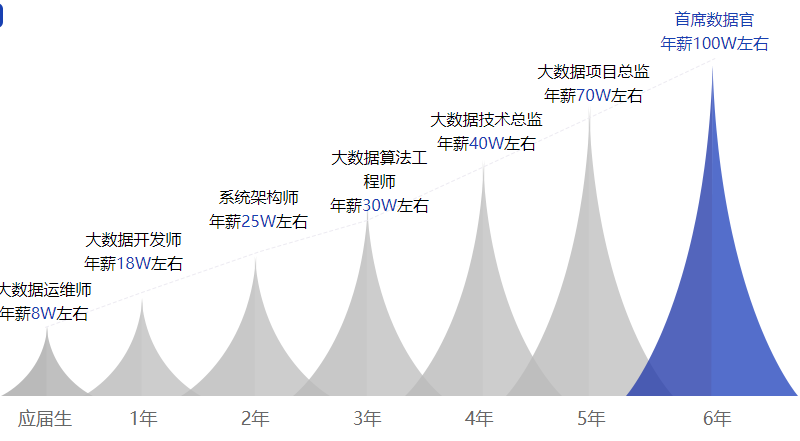

薪资待遇随工作年限呈阶梯式上涨

只有想不想学,没有能不能学

理论、实战双向并行,奠定入行扎实基础

第一阶段 Java语言基础 | Java语言基础: Java语言入门、基本语法、面向对象、常用API、异常、集合、IO流、多线程、网络编程、反射、JDK新特性、MySQL数据库、JDBC 培养方向: 了解Java语言的特征和应用领域;掌握JDK、JRE和JVM的作用;能够成功搭建Java开发环境;完成HelloWorld程序的编写;掌握IDE工具IDEA的使用方式; 掌握Java基本语法中的常量、变量的声明和使用;掌握Java中的运算符、数据类型及其相互转换;掌握分支结构、循环结构、方法的定义和使用;掌握数组的使用,理解数组的内存结构; 掌握面向对象的编程思想;掌握类和对象的定义和使用;理解封装、继承、多态等特性;掌握抽象类、接口的特点和使用方式;充分理解并运用Java面向对象思想来进行程序开发; 掌握Java中的常用类和工具类的使用,能够使用这些常用类和工具类解决多种问题; 掌握Maven项目构建和依赖管理、掌握Maven的继承和聚合; |

第二阶段 Hadoop技术栈 | Hadoop技术栈 Linux、Hadoop、ZooKeeper、Hive、HBase、海王星大数据金融平台 培养方向: 掌握Linux操作系统安装及常用命令;掌握shell脚本编程; 掌握大数据架构Hadoop原理及编程应用;掌握Hadoop三大组件的使用方式、方法以及Hadoop调优; 掌握ZooKeeper协管理器工作机制以及动态感知原理及使用; 掌握Hive数据仓库的使用及调优原理; 掌握HBase数据库的开发、使用以及调优; 掌握消费金融业务处理流程;掌握根据业务制定合理技术框架(技术选型)的能力;大量数据的日志采集方案;数仓的分层搭建以及数仓建模;掌握大量数据的ETL处理方式;掌握工作流调度解决方案;掌握即席查询工具使用及其原理;掌握数据可视化报表工具的使用;掌握数据治理框架的原理以及使用;掌握集群指标监控工具的使用 职业方向: Hadoop开发工程师、数据仓库工程师、ETL开发工程师、离线开发工程师 |

第三阶段 Spark技术栈 | Spark技术栈 Scala、Kafka、Spark、交通流量实时可视化大屏 培养方向: 掌握Scala基本语法和进阶的使用,为学习Spark、Flink框架打下基础; 掌握消息队列概念、Kafka原理架构、日志合并、消息检索; 掌握分布式内存计算、RDD、DataSet、DStream概念; 掌握离线计算、流式计算; 掌握可视化大屏内在价值与用途;掌握实时流数据分析业务处理流程;掌握Flume+Kafka+Sparkstreaming+Redis架构整合;掌握Springboot的使用;掌握websocket操作使用;了解Echarts的使用方式 职业方向: Spark开发工程师、实时开发工程师 |

第四阶段 Flink流式处理框架 | Flink流式处理框架: Flink、ClickHouse、畅游天涯旅游实时分析项目 培养方向: 掌握Flink的原理;掌握Flink的使用以及与其他技术的整合; 掌握ClickHouse架构、速度快的原因;掌握ClickHouse数据库和表引擎;掌握ClickHouse基本操作以及和spark、flink的整合; 掌握旅游行业业务流程;掌握Flink在实时计算业务中的使用;掌握自定义Flink source和sink来生成和消费Kafka数据;掌握Flink和ClickHouse整合已存储数据;掌握搜索引擎Elasticsearch;掌握Flink和Elasticsearch整合;掌握基于Flink CEP处理复杂事件 职业方向: Flink开发工程师、实时开发工程师、实时数仓工程师 |

第五阶段 项目实战 | 项目实战: EWR消费信用风险舆情系统、Monoceros物流大数据平台、物流Kubernetes+Docker项目迁移 培养方向: 掌握信贷金融业务处理流程;掌握根据业务制定合理的技术框架(技术选型);掌握当下流行的数据中台概念;掌握前台工作整体机制以及技术应用;掌握后台综合分析展示应用系统;掌握大量数据的综合采集方案;掌握大量数据的ETL处理方式;掌握工作流调度解决方案;掌握集群指标监控工具的使用; 掌握基于亿级订单的物流大数据平台的研发;掌握基于Flink实现仓库货物、仓储车运动轨迹、包裹追踪等多维度业务分析;具备基于HDP平台收集数据资源的能力,实现秒级OLAP分析; 掌握Docker容器化技术以及应用;掌握Kubernetes核心功能以及在项目中的部署应用 职业方向: 数据仓库工程师、ETL开发工程师、离线开发工程师、实时开发工程师、数据中台工程师 |

第六阶段 就业指导 | 就业指导: 企业面试前期准备与技巧、专业指导、企业面试复盘 课程内容: 职业规划讲解、简历注意事项详解、就业情况分析简历制作(个人技能、项目经验、自我评价); 简历审核修正、常见面试题的讲解、技术简历的指导与优化、强化实战项目(项目模块的介绍,业务流程的梳理); 真实面试复盘(晚自习时间)(总结学员面试中的问题,进行针对性的辅导以及相关面试题的讲解) 培养方向: 从简历、面试技巧等层面助力学员,培养学员沟通表达能力 让学员清晰了解职业发展规划,明确自身定位,找到适合自身发展的工作; 通过项目强化、面试专项指导、面试复盘等,学员能更好就业 |

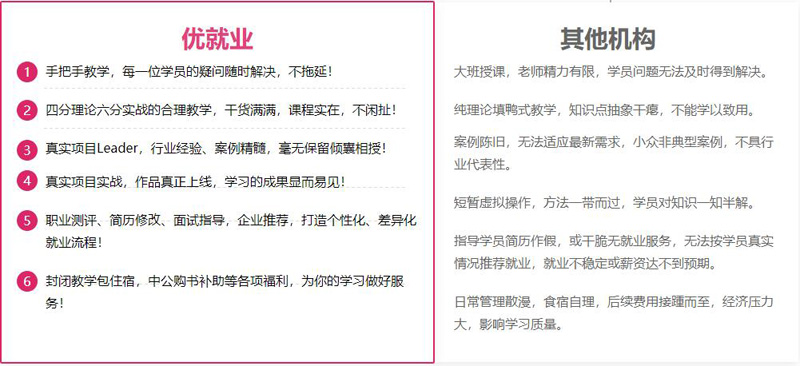

一路暖心服务,不怕您货比三家

大数据培训资料

Spark体系结构具有两个主要的守护程序以及一个集群管理器。它基本上是一个主/从体系结构。这两个守护程序是:

主守护程序:它处理主/驱动程序过程

辅助进程:处理从进程

一个Spark集群只有一个Master和许多Slave / Worker。单个Java进程由驱动程序和执行程序运行,而用户可以在不同的机器(如垂直集群或混合机器配置,甚至在同一水平的Spark集群)上运行它们。

Spark体系结构:驱动程序,执行程序和集群管理器的角色

1、驱动程序:是运行应用程序的primary()函数的中心点。它也是Spark Shell(Scala,Python和R)的入口。Spark Context在这里构建。驱动程序的组件包括:

DAGS调度程序

任务计划程序

后端调度程序

块管理器

所有这些负责将spark用户代码转换为在集群上实现的实际spark作业。驱动程序的角色是:

在Spark集群的主节点上运行的驱动程序有助于计划作业的执行,并有助于与集群管理器进行协商。

它有助于将RDD转换为执行图,然后将其分为多个阶段。

有关RDD及其分区的元数据也由驱动程序存储。

驱动程序有助于将用户应用程序转换为较小的任务,这些任务又由执行者执行。后一种是处理单个任务的工作进程。

它还有助于通过端口4040上的Web UI揭示有关运行spark应用程序的信息。

2、执行者:执行者主要负责执行任务。它是一个分布式代理。每个Spark应用程序都具有自己的流程执行器,该执行器在Spark应用程序的整个生命周期内运行。这称为“执行者的静态分配”。用户还可以选择执行者的动态分配,在其中动态添加或删除执行者以匹配整体工作量。执行者的角色是:

数据处理

它有助于读取和写入外部数据

它有助于将计算结果数据存储在内存,HDD或缓存中。

它有助于与存储系统进行交互

3、集群管理器:为每个应用程序选择集群管理器Spark完全取决于目标,因为集群管理器提供了不同的调度功能集。在开发新的Spark应用程序时,独立集群管理器更易于使用。Spark应用程序可以利用三种类型的集群管理器来分配和取消分配各种物理资源,例如客户端Spark作业,CPU内存等。

Spark应用程序的运行时架构 当客户端提交Spark应用程序代码时,驱动程序会将其隐式转换为逻辑DAG。各种优化,例如对转换进行流水线处理,然后将逻辑DAG转换为具有一组阶段的物理执行计划。

在创建具有各种小型物理执行单元的物理执行计划后,即创建了称为任务的任务,这些任务组合在一起并发送到Spark集群。然后,驱动程序与集群管理器进行交互,并进行资源协商。

它是集群管理器,这有助于在从属节点上启动执行程序。驱动程序根据数据放置将任务发送到集群管理器,执行程序在执行前先向驱动程序注册。驱动程序将在应用程序运行时对其进行监视。驾驶员还将根据数据放置再次计划将来的任务。当驱动程序main()方法退出或stop()方法退出时,它将终止所有执行程序并将其从集群管理器中释放。

结个小论 以上架构列举了其易用性、可访问性以及处理大数据任务的能力,也最终由于其速度而在Hadoop中占主导地位。它已将Hadoop MapReduce提升到了一个全新的水平,在以下行业中,Spark实时数据分析功能更是得到全面的应用:

政府:实时分析在政府机构中的最大用途在于国家安全领域,因为几乎所有国家都必须实时跟踪军事和警察的最新动态,以防威胁国家安全。

医疗保健:实时分析对于检查某些危重病人的病史非常有用,这有助于他们追踪血液和器官之间的移植情况。这在极端的医疗紧急情况下非常有用,因为在紧急情况下延迟几秒钟可能会导致生命损失。

银行业务:世界通过银行业务进行货币交易,因此,确保交易不存在欺诈行为至关重要。

股票交易所:股票经纪人使用实时分析来预测股票走势。许多企业通过使用实时分析来检查其品牌的市场需求来更改其业务模型。

扫描二维码免费领取试听课程

登录51乐学网

注册51乐学网